Hoe Microsoft Fabric Mijn Datawerk Revolutioneerde: Een Persoonlijk Verhaal

Toen ik voor het eerst met Microsoft Fabric werkte, voelde het alsof ik na jaren puzzelen eindelijk alle stukjes op hun plek zag vallen. Als data professional die dagelijks werkt met verschillende tools, was ik sceptisch over nóg een platform. Maar Fabric bleek anders. Dit is mijn verhaal.

"Fabric voelt als een warm bad voor data professionals - alles werkt samen zoals het hoort, zonder gedoe met integraties"

De Aha-Momenten

Mijn eerste week met Fabric verliep anders dan verwacht. Waar ik gewend was om uren te besteden aan:

- Infrastructuur configureren

- API-koppelingen debuggen

- Data tussen systemen heen en weer slepen

Kon ik nu gewoon... aan de slag. En dat veranderde alles.

Wat Ik het Meest Waardeer

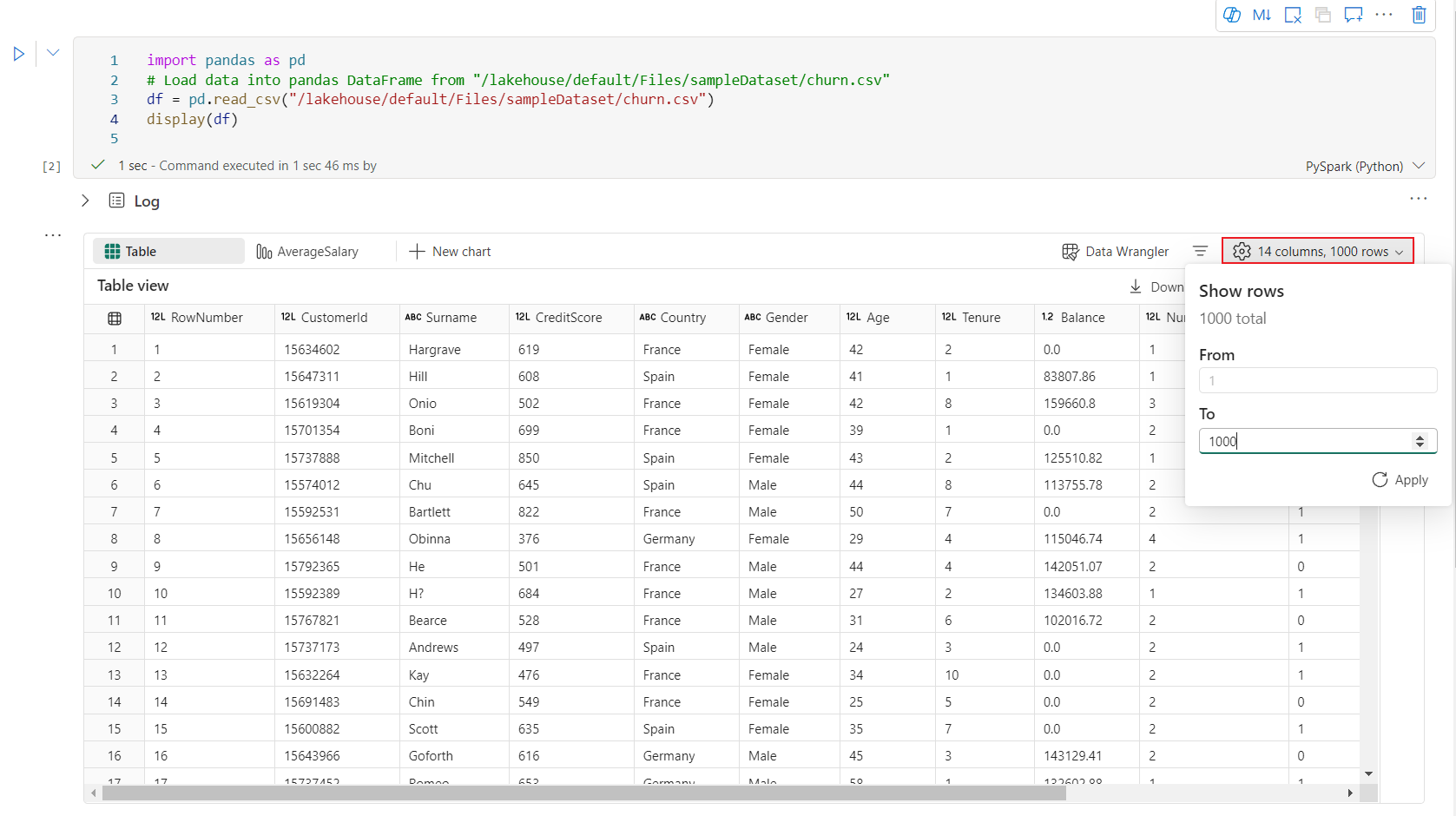

1. Notebooks Die Echt Werken

Als fervent gebruiker van Jupyter-notebooks was ik verrast door de naadloze integratie in Fabric:

- Directe toegang tot OneLake: Geen gedoe meer met mount points

- Live samenwerken: Alsof je Google Docs voor data science hebt

- Geen runtime-issues: De Spark-sessies "just work"

Mijn favoriete functie? De mogelijkheid om vanuit een notebook direct een Power BI-dataset te publiceren. Dat scheelde me alleen al tientallen uren per maand.

2. Alles Onder Één Dak

Voorheen gebruikte ik:

| Vroeger | Nu met Fabric |

|---|---|

| Azure Data Factory + Synapse | Geïntegreerde Data Factory |

| Aparte Spark-clusters | Ingenomen Spark in workspace |

| Handmatige Power BI koppelingen | Directe publicatie vanuit Fabric |

3. Real-Time Analytics Die Toegankelijk Is

Wat mij betreft het meest ondergewaardeerde onderdeel: Synapse Real-Time Analytics. Ik gebruik het nu voor:

- Live monitoring van IoT-data voor klanten

- Directe KQL-query's op streaming data

- Combinaties met batch-data in dezelfde interface

Uitdagingen Die Ik Tegenkwam

Natuurlijk was niet alles rozengeur en maneschijn:

1. Licentiemodel

De overstap naar capaciteitsunits (CU's) was even puzzelen. Vooral het inschatten van het benodigde vermogen voor:

- Gelijktijdige gebruikers

- Complexe Spark-jobs

- Piekbelastingen

Gelukkig biedt de automatische schaling uitkomst.

2. Leercurve voor Teams

Collega's die gewend waren aan losse tools, moesten wennen aan:

- Het nieuwe autorisatiemodel

- Workspace-concept

- Geïntegreerde metadata

Na een maand was iedereen om - de productiviteitswinst was te duidelijk.

Mijn Tips voor Beginners

- Begin klein: Maak één end-to-end pipeline voor een simpele use case

- Gebruik de templates: Fabric biedt kant-en-klare oplossingen voor veel scenario's

- Experimenteer met Copilot: De AI-assistent verrast je positief

- Combineer services: De magie zit in de integratie tussen componenten

Conclusie: Waarom Ik Blijf Gebruiken

Na een half jaar Fabric kan ik zeggen: dit platform heeft mijn workflow fundamenteel verbeterd. Wat ik vooral waardeer:

- Tijdsbesparing: Minder tijd aan infra, meer tijd aan waarde toevoegen

- Consistentie: Eén omgeving voor alle data-activiteiten

- Plezier: Het werkt gewoon zoals je hoopt dat het werkt

Voor Nederlandse MKB'ers en grotere organisaties zie ik Fabric als gamechanger. Het combineert de kracht van enterprise-oplossingen met de eenvoud die kleinere teams nodig hebben.

← Terug naar het blogoverzicht